Por trabalhar com software, Jacky Alciné percebeu logo que descobriu o problema que havia uma falha no algoritmo, não uma ação intencional do Google em prol do racismo. Porém, o desenvolvedor questionou que tipos de imagens o sistema do serviço estaria usando como parâmetros de comparação. Para ele, uma classificação mais precisa e completa de pessoas negras deixaria o algoritmo mais bem treinado para não cometer esse tipo de erro. O Google rapidamente pediu desculpas e prometeu investigar o problema, chegando a pedir autorização a Alciné para acessar a sua conta para obter mais detalhes. Mas, aparentemente, nenhuma solução foi desenvolvida desde então.

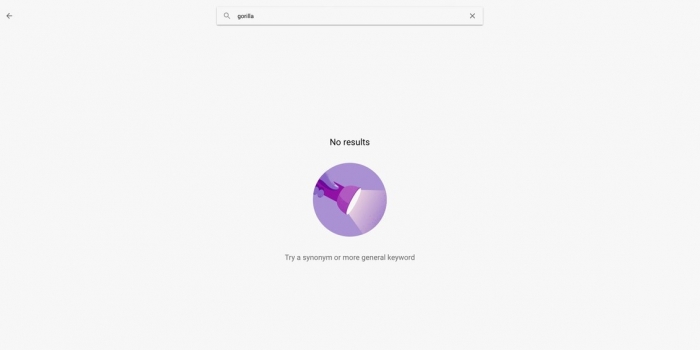

— Jacky Alciné (@jackyalcine) June 29, 2015 A descoberta foi feita pela Wired, que testou mais de 40 mil imagens no Google Fotos. O serviço classificou corretamente diversos tipos de animais, até alguns supostamente mais trabalhosos, como pandas e poodles. Em compensação, buscas (em inglês) por chipanzé, gorila e macaco não trouxeram resultados. Qual a explicação para isso se buscas sobre primatas como orangotango e babuíno funcionaram perfeitamente? A Wired logo presumiu que o Google simplesmente baniu por tempo indeterminado palavras que podem ocasionar problemas de cunho racial.

Surpreendentemente, o Google reconheceu o bloqueio. As categorias haviam sido barradas assim que Alciné reportou o problema e estão assim até hoje. Um represente da companhia explicou à Wired que a “tecnologia de reconhecimento de imagens ainda é nova e, infelizmente, está longe de ser perfeita”. Fica a dúvida: o Google não conseguiu solucionar o problema ou simplesmente deixou-o para depois? Pode ser uma mistura dos dois. Especialistas em inteligência artificial reconhecem que a tecnologia está longe de ter a capacidade de abstração e análise contextual dos humanos. Nesse sentido, o caminho mais fácil (o bloqueio de categorias) parece mesmo ser o mais seguro.